SEO

SEOПравильный robots.txt

Файл robots.txt указывает поисковым ботам, какие именно страницы на сайте нужно индексировать. Иногда им пренебрегают, так как он не влияет на ранжирование, но это неверный подход, потому что robots.txt может быть очень полезен. Во-первых, он указывает поисковым машинам, какие страницы можно индексировать, а какие нельзя. Иногда имеет смысл скрыть от поисковиков часть контента, который предназначен для вашего личного пользования, или полностью спрятать сайт, если он, к примеру, находится на реконструкции. Кроме того, правильно написанный файл robots.txt защищает сайт от спам-ботов, которые проводят сканирование на предмет электронных почт для последующих рассылок. Ниже мы рассмотрим, как создать правильный robots.txt.

Как создать robots.txt

Несмотря на всю важность, которую несет robots.txt, создается он элементарно. Файл можно легко написать самостоятельно в блокноте и разместить в корневой директории ресурса. Для этого не требуется дополнительного софта или знания языков программирования. Команды, которые содержит файл, однотипны, поэтому составление robots.txt по силам любому новичку. Ниже мы разберем, что же именно он должен в себя включать.

Директивы robots.txt

Директива user-agent

Файл будет содержать информацию о том, как должен вести себя каждый конкретный поисковик, и к ним он будет обращаться посредством директивы User-agent.

Если всем ботам вы ходите дать одинаковые инструкции, то директива будет выглядеть таким образом:

User-agent: *

Однако здесь можно дать инструкцию любому поисковику, если знать, как к ним обращаться. Разберем два наиболее популярных. Для Google и Яндекса данная директива будет выглядеть следующим образом:

User-agent: Googlebot

User-agent: Yandex

Директива Disallow в robots.txt — запретить индексацию

Вторая обязательная директива – это Disallow. Она указывает на те страницы или целые папки, которые не нужно индексировать, например:

Disallоw: /index.html

Disallоw: /folder/

Для запрещения индексации всего сайта нужно в директиве поставить слэш:

Disallоw: /

Также есть возможность запретить индексировать часть файлов, объединенных определенным признаком. В примере ниже мы запрещаем ботам индексировать не только папку index, но и все файлы, начинающиеся со слова index:

Disallow: /index

Директива Allow

Если необходимо добавить исключения в это правило, на помощь приходит разрешающая директива Allow:

User-agent: Yandex

Disallоw: /index

Allow: /index15.html

Для директив Allow и Disallow возможно употребление знака звездочки, например, для применения ко всем файлам одного расширения:

Disallow: *.jpg

Кроме этого, параметры этих директив могут содержать и пустые значения.

User-agent: *

Disallow:

User-agent: *

Allow: /

Два варианта выше равнозначны, и если они будут прописаны, то это значит, что ни одна страница на сайте не будет запрещена для индексации. Два варианта ниже, наоборот, ставят полный запрет:

User-agent: *

Allow:

User-agent: *

Disallow: /

Директива Sitemap

Желательно использование директивы Sitemap, благодаря которой робот быстрее сориентируется во всех страницах ресурса:

Sitemap: /sitemap.xml

Директива Clean-param

На сайте возможно наличие динамических страниц, то есть тех, которые имеют идентичное содержание, но при этом разные ссылки. Таких страниц может быть бесконечное множество, для того, чтобы их убрать, нужно воспользоваться директивой clean-param, которая имеет следующий вид:

Clean-param: parm1[&parm2&parm3&parm4&..&parmn] [Путь]

Например, УРЛ сайта имеет вид:

www.site.com/page.html?&parm1=1&parm2=2&parm3=3

Директива может принять, в этом случае, следующие значения:

Clean-param: parm1&parm2&parm3 /page.html # только для page.html

или

Clean-param: parm1&parm2&parm3 / # для всех

Кстати, как вы могли заметить, в этих строчках используется символ решетки — в robots.txt он обозначает комментарий, и все, что написано после него до конца строки, поисковиком восприниматься не будет.

Как создать robots.txt онлайн

По сути, в создании файла robots.txt, однако если нет желания создавать его вручную, можно воспользоваться каким-либо онлайн-генератором, например, sitespy.ru или mediasova.com, однако учтите, что такой способ может оказаться неподходящим, из-за того, что при автоматической генерации не будут учтены страницы, которые нужно скрыть, или наоборот. Поэтому если уж вы выбрали создание robots.txt онлайн, то тщательно проверьте, какой файл вам будет предложен.

robots.txt для Яндекса и Гугла

Существуют свои особенности написания команд для Яндекса и Гугла. Например, директива Host, воспринимаемая только Яндексом, обязательна для использования и предназначена для того, чтобы не индексировались зеркала ресурса. Следовательно, содержание robots.txt будет таким:

User-agent: Yandex

Disallow: /index.html

Host: site.com

User-agent: Googlebot

Disallow: /index.html

В случае с Гуглом, в директиве User-agent можно прописать Googlebot-image или Googlebot-mobile – для индексации изображений и для сайтов, рассчитанных на мобильные устройства, соответственно.

Правила написания robots.txt

Несмотря на то, что у поисковиков могут быть разные принципы прочтения файла, правильно составить robots.txt не так и трудно, нужно лишь соблюдать его синтаксис, и проблем возникнуть не должно. Вот список основных правил, которым необходимо следовать:

- На каждую строку отводится только одна директива

- В параметрах директивы не стоит использовать кавычки или точку с запятой

- Строка не должна начинаться с пробела

- В директивах Allow и Disallow нужно указывать не более одного параметра

- В названии самого файла robots.txt не должно быть заглавных букв, только строчные

- Директивы и параметры также не следует писать заглавными буквами

- Если параметр директивы является директорией вашего сайта, то перед ней должен быть знак слэша (/), без разделения пробелом

- robots.txt воспринимает только латиницу

- Пустой файл, либо по каким-то причинам недоступный, или файл свыше 32 Кб будет считаться полностью разрешающим

- Команда в robots.txt указывается в формате: [Имя_директивы]:[необязательный пробел][значение][необязательный пробел]

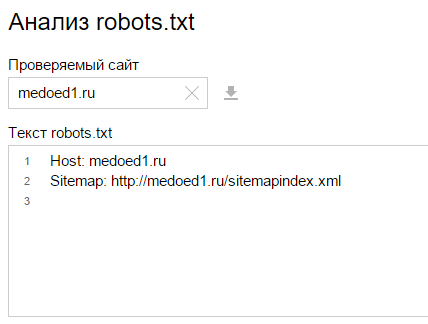

Как проверить robots.txt

Для того, чтобы проверить, насколько корректно работает robots.txt для вашего сайта, достаточно зайти в Яндекс.Вебмастер и на странице «Проверить robots.txt» ввести данные своего сайта.

Как видите, в написании robots.txt нет ничего сложного, а эффект от этих нескольких строчек можно получить очень полезный.

/rating_on.png)